Развёртывание платформы и отказоустойчивого кластера

Сценарий описывает:

- установку платформы;

- создание отказоустойчивого кластера с внешним хранилищем;

- настройку сетевой инфраструктуры.

Для реализации сценария потребуется:

- действующая лицензия VMmanager Infrastructure. Лицензия должна включать не менее 12 ядер CPU. Подробнее см. в статье Лицензирование;

- сервер для установки платформы с подключением к Интернет (P1). Подробнее см. в статье Требования к серверу;

три сервера для узлов кластера с подключением к Интернет (N1, N2, N3). Каждый сервер должнен соответствовать требованиям к узлам кластера и иметь не менее двух сетевых интерфейсов;

- внешнее сетевое хранилище. Хранилище может быть аппаратным, программным специализированным (например, TrueNAS) или на базе ОС Linux. Хранилище на базе ОС Linux рекомендуется использовать только для тестирования системы. Объём дискового пространства хранилища определяется из учёта потребностей:

- количества создаваемых ВМ;

количества создаваемых образов и резервных копий ВМ;

количества шаблонов ОС;

- автоматизированное рабочее место (АРМ) для удалённого подключения к серверам.

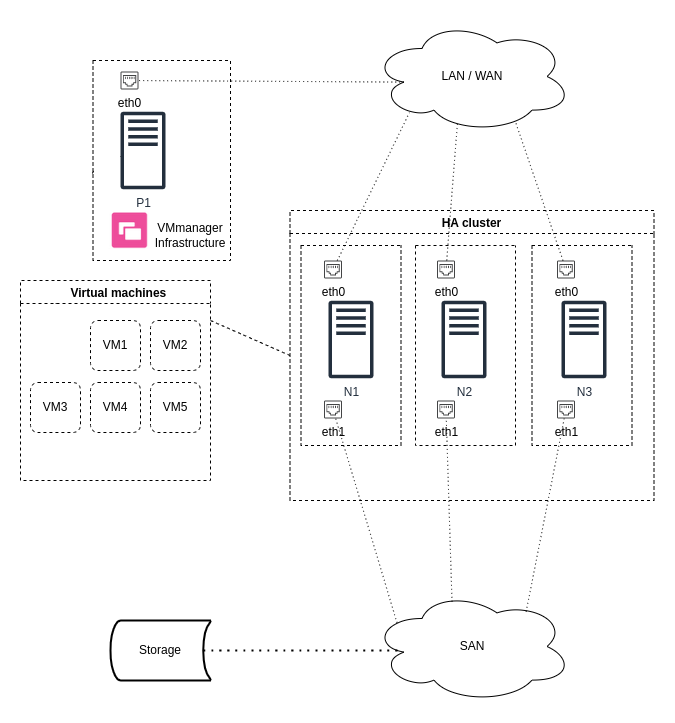

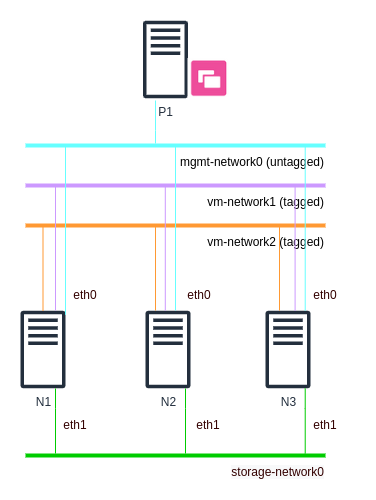

Схема работы

Пояснения к схеме:

- P1 — сервер для установки платформы;

- N1, N2, N3 — серверы для узлов кластера;

- HA cluster — отказоустойчивый кластер VMmanager;

- Virtual machines — виртуальные машины кластера;

- Storage — внешнее сетевое хранилище;

- eth0, eth1 — сетевые интерфейсы серверов;

- LAN/WAN — сети для взаимодействия узлов кластера и платформы;

- SAN — сети для взаимодействия узлов кластера с сетевым хранилищем.

Шаг 1. Подготовка оборудования

АРМ

- Убедитесь, что АРМ подключено к Интернет.

- При необходимости установите интернет-браузер и SSH-клиент.

- Настройте подключение к серверам по SSH:

- Откройте окно терминала или командную строку.

Создайте ключ SSH:

ssh-keygenCODE- Укажите имя и путь к файлу для SSH-ключей. По умолчанию в ОС Windows SSH-ключ сохранится в директории C:\Users\<имя_пользователя>\.ssh\, в ОС семейства Unix — в /home/<имя_пользователя>/.ssh/. По умолчанию закрытый ключ сохраняется в файл id_rsa, открытый — в id_rsa.pub.

Добавьте содержимое открытого ключа в файл /root/.ssh/authorized_keys на каждом сервере. В Unix-системах вы можете использовать для этого команду:

ssh-copy-id -i <path_to_key> root@hostBASHПояснения к команде<path_to_key> — путь к файлу с открытым SSH-ключом

host — IP-адрес или доменное имя удалённого сервера

Сервер для установки платформы

- Убедитесь, что выполнены все требования и рекомендации из статьи Требования к серверу.

- Если на сервере установлена ОС Astra Linux, выполните действия из статьи Подготовка сервера с ОС Astra Linux.

Синхронизируйте системное время с NTP-сервером:

ntpdate pool.ntp.orgBASH

Внешнее хранилище

Если вы используете аппаратное или программное специализированное хранилище, настройте его согласно документации к оборудованию.

Если вы используете хранилище на базе ОС Linux, выполните его предварительную настройку по инструкции из статьи Предварительная настройка SAN.

Серверы для узлов кластера

- Убедитесь, что выполнены все требования и рекомендации из статьи Требования к серверу для кластера.

- Настройте серверы для работы с внешним хранилищем по инструкции из статьи Предварительная настройка SAN.

Определите путь к блочному устройству хранилища через UUID. Для этого выполните команду:

blkid -o export <device>BASHПояснения к команде<device> — путь к блочному устройству хранилища в формате /dev/disk. Например, /dev/sdb

Пример вывода команды

DEVNAME=/dev/sdb UUID=42d8aa74-143a-454e-b3d2-b719f13b5a22CODEПуть к устройству с UUID будет иметь вид /dev/disk/by-uuid/<UUID>. Например, /dev/disk/by-uuid/42d8aa74-143a-454e-b3d2-b719f13b5a22. Сохраните это значение. Оно понадобится при подключении сетевого хранилища.

Синхронизируйте системное время с NTP-сервером:

ntpdate pool.ntp.orgBASH

Шаг 2. Установка платформы

- Сохраните ключ активации (токен) лицензии. Если вы приобрели лицензию в ISPsystem, зайдите в личный кабинет my.ispsystem.com → перейдите в раздел Лицензии → откройте информацию о лицензии → сохраните значение Token.

Подключитесь к серверу P1 по SSH с правами суперпользователя:

ssh root@hostCODEПояснения к командеhost — доменное имя или IP-адрес сервера

- Установите VMmanager (подробные инструкции см. в статье Установка):

Скачайте установщик:

curl -O https://download.ispsystem.com/6/installer/vm/vmCODEСделайте файл установщика исполняемым:

chmod +x vmCODEЗапустите установку, используя ключ активации (токен) лицензии:

./vm install -l="<token>"CODEПояснения к команде<token> — значение параметра Token для вашей лицензии

Дождитесь окончания установки. Если установка завершилась успешно, то в терминале будет выведена ссылка для перехода в VMmanager:

Пример терминала после успешной установки

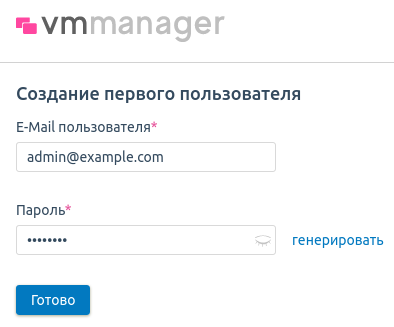

Link to administrator registration page: https://1.2.3.4/auth/setup?token=C50A0BFA55DEDE3343AABE713022A15FBASH- Откройте полученную ссылку в браузере и создайте первого пользователя:

- Введите E-Mail пользователя.

- Придумайте Пароль или нажмите генерировать для автоматической генерации пароля.

- Нажмите Готово.

- При успешной авторизации в браузере откроется форма начальной настройки платформы. Нажмите кнопку Пропустить начальную настройку.

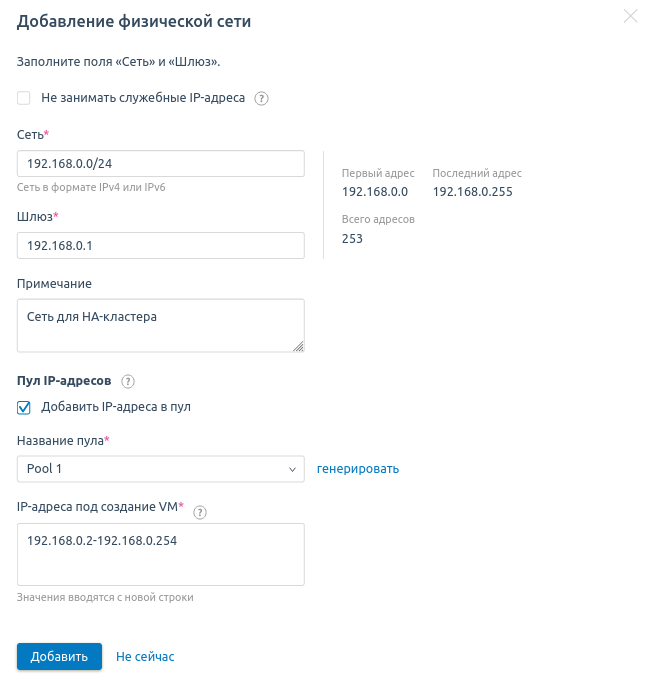

Шаг 3. Настройка сети

VMmanager содержит модуль управления адресным пространством (IPAM) — физическими сетями, пулами и отдельными IP-адресами. При создании ВМ платформа выделяет ей IP-адрес из заданного пула. Поэтому перед созданием ВМ необходимо указать данные о физической сети и настроить пул IP-адресов для ВМ.

Чтобы настроить сеть и пул:

- Перейдите в раздел Сети → вкладка Физические сети.

- Нажмите кнопку Добавить физическую сеть.

- Укажите Сеть в формате <адрес сети>/<префикс маски сети>. Например, "192.168.0.0/16".

- При необходимости измените IP-адрес Шлюза.

- Укажите произвольное Примечание.

- Включите опцию Добавить IP-адреса в пул.

- Введите Название пула — Pool 1.

- Укажите IP-адреса под создание VM. Вы можете указать:

- отдельные адреса ("192.168.1.1");

- адреса по префиксу маски ("192.168.1.0/24");

- диапазон адресов ("192.168.1.1-192.168.10.254").

- Нажмите кнопку Добавить.

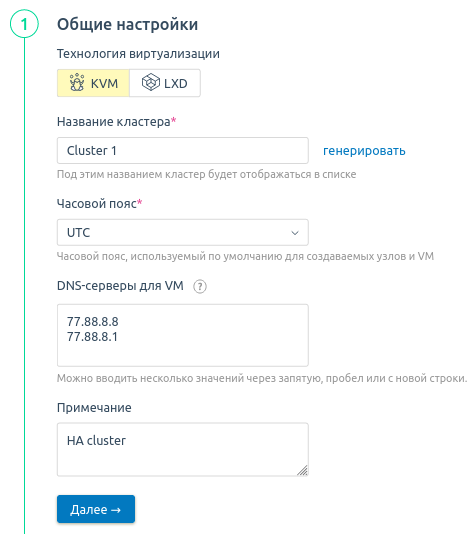

Шаг 4. Создание кластера

Создайте кластер по инструкции из статьи Создание кластера. При создании кластера:

- Выберите Технологию виртуализации — KVM.

- Укажите Название кластера — Cluster 1.

- Укажите DNS-серверы для VM. Например, DNS-серверы Яндекса 77.88.8.8, 77.88.8.1.

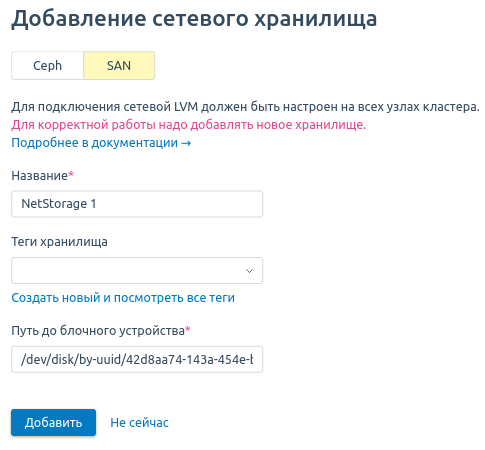

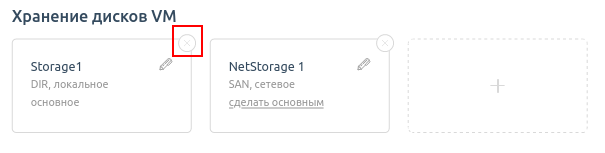

- Добавьте сетевое хранилище NetStorage 1 с типом SAN. Укажите Путь до блочного устройства, полученный при подготовке узлов на Шаге 1.

- К отказоустойчивому кластеру не должны быть подключены локальные хранилища. Чтобы удалить локальное файловое хранилище по умолчанию, в виджете с хранилищем Storage 1 нажмите значок

.

.

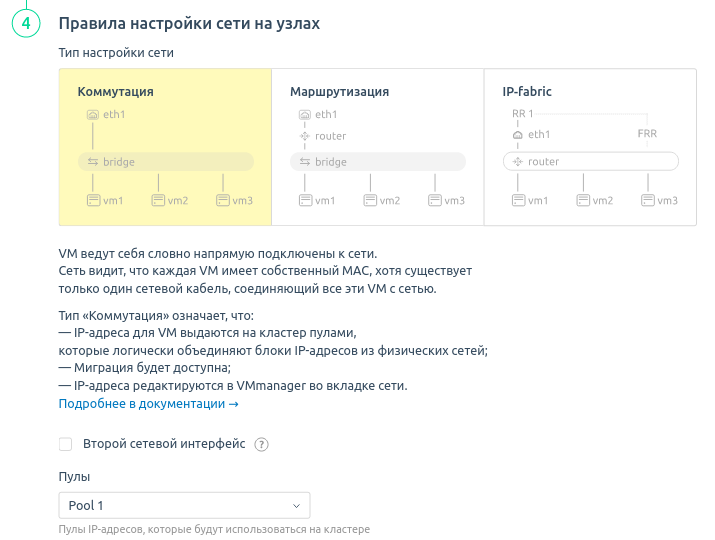

- Выберите Тип настройки сети — Коммутация.

- В поле Пулы выберите пул, созданный на Шаге 3 — Pool 1.

Шаг 5. Добавление узлов в кластер

- В интерфейсе платформы перейдите в раздел Узлы.

- Нажмите кнопку Подключить узел.

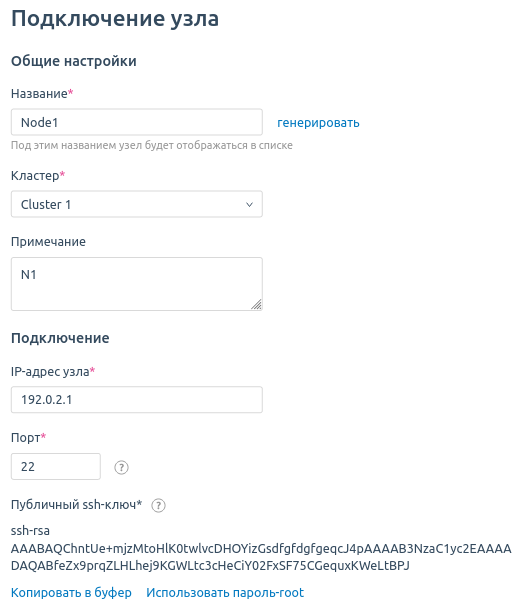

- Укажите настройки узла:

- Введите Название узла кластера — Node 1.

- Выберите Кластер, к которому будет подключён узел — Cluster 1.

- Укажите IP-адрес сервера N1 и Порт для подключения по протоколу SSH. Если вы не меняли настройки SSH на узле, оставьте значение по умолчанию.

- Нажмите Хочу использовать публичный ssh-ключ и сохраните содержимое ключа.

- Подключитесь к серверу N1 по SSH и добавьте содержимое открытого ключа в файл /root/.ssh/authorized_keys.

- Для остальных настроек оставьте значения по умолчанию.

- Нажмите Подключить узел.

- Выполните пп. 2-4 для серверов N2 и N3. В качестве названия узла укажите Node 2 и Node 3.

Шаг 6. Настройка сетевой инфраструктуры

- Настройте VLAN для разделения управляющего трафика, трафика ВМ и подключения к хранилищу. Чтобы разделить трафик внутри одного физического интерфейса, создайте необходимые бриджи на узлах кластера. Подробнее см. в статье Настройки сети на узле кластера.

- Разрешите передачу трафика между созданными VLAN на портах коммутатора, к которым подключено оборудование.

Настройте маппинг между сетевыми интерфейсами, подключёнными к SAN, и сетевым хранилищем.

Настройте подключение сетевого хранилища с использованием технологии multipath.

Пример схемы сети

Пояснения к схеме:

- P1 — сервер с платформой;

- N1, N2, N3 — узлы кластера;

- mgmt-network0 (untagged) — сеть для управляющего трафика узлов кластера (трафик нетегированный);

- vm-network1, vm-network2 — сети для трафика ВМ (трафик тегированный);

- storage-network0 — сеть для трафика подключения к внешнему хранилищу;

- eth0, eth1 — сетевые интерфейсы на узлах кластеров.

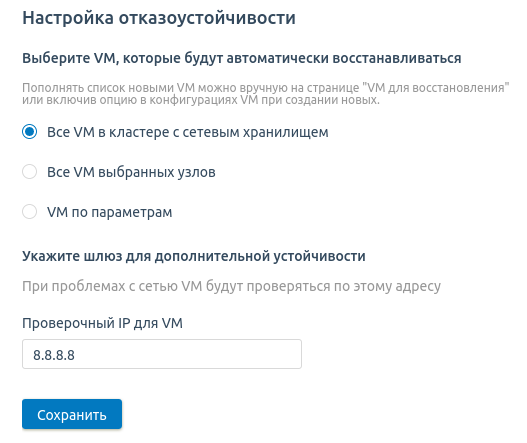

Шаг 7. Настройка отказоустойчивости

- Перейдите в Кластеры → выберите кластер → раздел Отказоустойчивость.

- Нажмите кнопку Включить отказоустойчивость.

- Укажите настройки:

- Выберите опцию Все VM в кластере с сетевым хранилищем.

В поле Проверочный IP для VM введите IP-адрес, который будет использоваться для проверки связности.

Если у всех узлов один и тот же шлюз, укажите IP-адрес шлюза. Если нет, то внешний IP-адрес. Например, 8.8.8.8.

- Нажмите Сохранить.

Шаг 8. Проверка отказоустойчивости

- Создайте 5 ВМ по инструкции из статьи Создание виртуальных машин. В качестве узла кластера выберите Node 1.

- Отключите сервер N1. Если отказоустойчивость настроена успешно, платформа восстановит работу ВМ на узлах Node 2 и Node 3.